读、写及输出千万行数据不用等下一分钟

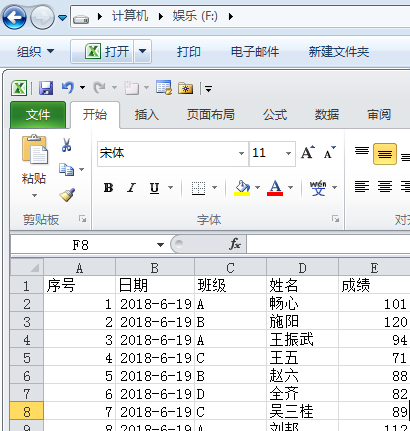

假设本地F盘保存了从系统导出的存有大量数据的test1.csv(丧心病狂的你面对几百M的csv心不会痛么?),内容如下:

现在我要读取并对大量数据操作或转储分割为小文件该如何操作?

power bi里面试着导入了一下,还好没死机。。。

导出就成了问题,知道有个复制按钮,但超过百万行的粘贴让人头大。。。

你们可以试着粘贴下,下面看python脚本怎么操作:

import pandas as pd

RT=pd.read_table('F:\\test1.csv',sep=',',chunksize=500000,encoding="gbk")

a=[]

for chunk in RT:

a.append(chunk)

x=pd.concat(a)

TL=print(len(x))

for t in range(4):

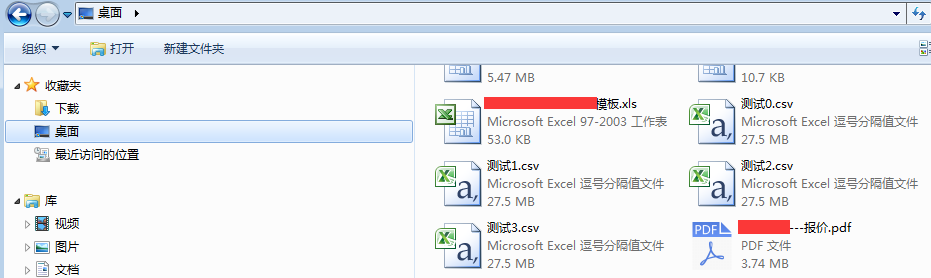

x[t*1000000:t*1000000+1000000].to_csv('C:/Users/Administrator/Desktop/测试'+str(t)+'.csv',encoding='gbk',index=False)

#1秒读千万数据我尝试着拿到拆分的前4个文件:

不要再说慢了,你真的没找对方法,这里还能继续优化成倍的提速,你也来试试吧!

道高一尺 魔高一丈

https://pbihub.cn/users/44

自由转载-非商用-非衍生-保持署名(创意共享3.0许可证)